Альтернативное видение ИИ как сверхразума, часть 1: скорость прогресса

Альтернативное видение ИИ как сверхразума, часть 1: скорость прогресса

Это вольный перевод статьи профессоров Пристонского университета, опубликованной 15 апреля 2025 года.

Первоисточник

Введение

На сегодняшний день формируется видение искусственного интеллекта как «рядовой технологии». Рассматривать ИИ как норму вовсе не даёт права недооценивать его влияние – даже такие на сегодняшний день фундаментальные технологии как электричество и интернет являются обычными в нашей концепции. Но это находится в контрасте и с утопическими, и антиутопическими представлениями о будущем ИИ, которые имеют общую тенденцию относиться к нему как к отдельному виду, потенциально автономной, сверхразумной сущности.

Утверждение «ИИ – рядовая технология» несёт в себе три вещи: описание текущего ИИ, прогноз его обозримого будущего и предписания о том, как следует с ним в дальнейшем обращаться. Мы рассматриваем ИИ как инструмент, который мы способны и должны контролировать и утверждаем, что эта цель не требует радикальных политических вмешательств или технологических прорывов. Мы не думаем, что рассматривать ИИ как человекоподобный интеллект в настоящее время является корректным или полезным для понимания социальных последствий, и вряд ли будет соответствовать нашему видению будущего.

Граница «рядовой технологии» касается взаимоотношений технологии и общества. Она отвергает технологический детерменизм («редукционистская теория, которая рисует технологию движущей силой развития человеческого общества» – прим. переводчика), особенно идею ИИ как самостоятельного агента, определяющее его будущее. Она руководствуется уроками прошлых технологических революций, как медленный и неопределенный характер принятия и распространения технологий. Она также подчеркивает преемственность между прошлой и будущей траекторией ИИ с точки зрения влияния на общество и роли институтов в формировании этой траектории.

Статья состоит из четырёх частей.

В первой мы объясняем, почему считаем, что преобразующие экономические и социальные воздействия будут медленными (речь о десятилетиях!), проводя принципиальное различие между методами, приложениями и внедрением искусственного интеллекта, утверждая, что эти процессы происходят в различные временные рамки.

Во второй мы порассуждаем о потенциальном разделении труда между людьми и искусственным интеллектом (но не «сверхразумным» ИИ, который мы считаем «непоследовательным» как это обычно позиционируется). В этом мире контроль в первую очередь находится в руках людей и организаций, однако, всё большая доля того, что люди делают на своей работе, начинает быть похожим на контроль искуственным интеллектом.

В третьей части мы рассмотрим последствия и риски становления ИИ в ряд обычных, рядовых технологий.

Конечно, мы не можем быть уверены в наших прогнозах, но мы стремимся описать то, что рассматриваем как нечто усреднённое. Мы не пытались оценить вероятности количественно, но мы постарались сделать прогнозы, способные сказать нам, сможет ли ИИ оказаться в рядовых технологиях.

В четвёртой мы обсудим последствия для политики использования ИИ. Мы выступаем за снижение неопределённости как за приоритетную политическую цель и за устойчивость как за всеобъемлющий подход к катастрофическим рискам. Мы утверждаем, что радикальные вмешательства, основанные на сложности контроля «сверх-ИИ», по нашему мнению, ухудшат ситуацию, если ИИ превратится в рядовую технологию, недостатки которой, скорее всего, будут отражать недостатки технологий предыдущих, которые были развернуты в капиталистических обществах как, например, неравенство.

Мир, который мы описываем во второй части – это мир, в котором ИИ гораздо более продвинут, чем существует на сегодняшний день. Мы не утверждаем, что прогресс ИИ или процесс человека в моменте остановится. Что будет после него? Мы не знаем. Рассмотрим аналогию: на заре первой промышленной революции было бы неплохо задуматься о том, как будет выглядеть индустриальный мир и как к нему подготовиться, но было бы бесполезно пытаться предсказать электричество и компьютеры. Данное упражнение идентично. Поскольку мы отвергаем сценарии «быстрого взлёта», мы не видим необходимым или полезным представлять себе мир дальше, чем мы пытались. Если и когда сценарий, описываемый в части 2, реализуется, мы сможем лучше предвидеть и подготовиться к тому, что будет дальше.

Это эссе имеет нестандартную цель – донести мировоззрение, а не защитить утверждение. Литература по сверх-ИИ на сегодняшний день существует в изобилии. Мы не пытались дать пошаговый ответ на потенциальные контраргументы, так как это сделало бы статью в несколько раз длиннее. Этот труд всего лишь первоначальное изложение наших взглядов, мы планируем их развивать в последующих работах.

Часть 1. Скорость прогресса

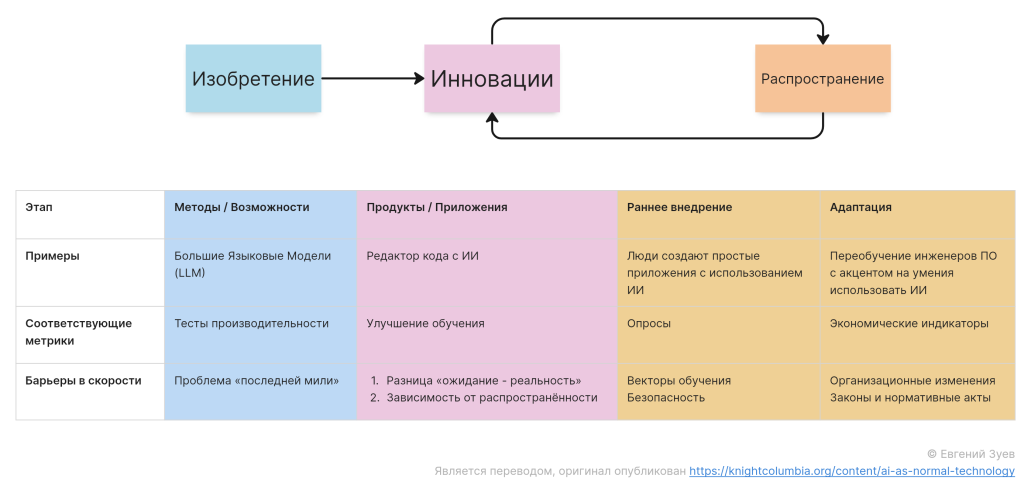

Рисунок 1. Как и другие технологии общего назначения, влияние ИИ проявляется не в совершенствовании методов и возможностей, а когда эти усовершенствования воплощаются в приложения и распространяются по производственным секторам экономики. На каждом шаге есть свои пределы скорости.

Будет ли прогресс ИИ постепенным, позволяя людям и учреждениям адаптироваться к росту возможностей ИИ, или мы будем наблюдать скачкообразное развитие, ведущее к масштабному нарушению или даже к состоянию технологической сингулярности? Наш подход – проанализировать задачи с высокой степенью значимости отдельно от задач с меньшей и начать с анализа скорости принятия и распространения ИИ, прежде чем вернуться к скорости инноваций и изобретений.

Обозначим термин «Изобретение» как веху разработки новых методов ИИ, например, большие языковые модели, которые расширяют возможности искусственного интеллекта для выполнения различных задач. «Инновация» относится к разработке продуктов и приложений с использованием ИИ, которые могут использовать бизнес и конечные потребители. «Внедрение» относится к решению конкретного индивидуума (или команды, или бизнеса) использовать технологию, тогда как «Распространение» относится к более широкому социальному процессу, посредством которого увеличивается уровень внедрения. Для достаточно революционных технологий распространение может потребовать изменений в структуре организаций, а также в социальных нормах и законах.

Распространение ИИ в областях, где безопасность критически важна, медленное.

В статье «Against Predictive Optimization» мы составили список из примерно 50 приложений предиктивной оптимизации, а именно использование ML для принятия решений в отношении индивидуумов путём прогнозирования их будущего поведения или результатов. Большинство этих приложений, таких как оценка риска совершения преступлений, риски страхования или прогнозирование жестокого обращения с детьми, используются для принятия решений, которые имеют важные последствия для людей. Не смотря на распространённость их использования, есть важный нюанс: в большинстве случаев используются статистические методы, созданные десятилетия назад – простые, интерпретируемые модели (в основном регрессионные) и относительно небольшие наборы созданных вручную признаков. Более комплексные методы машинного обучения, как, например, «метод случайного леса», используются редко, а современные методы нейросетевой архитектуры, как трансформеры, не используются вовсе.

Другими словами, в этом широком наборе областей распространение ИИ отстаёт на десятилетия от инноваций. Основной причиной является безопасность: когда модели более сложные и менее понятные, сложно предвидеть все возможные условия при тестировании и валидации процесса. Хороший пример – инструмент прогнозирования сепсиса от Epic, которые не смотря на кажущуюся высокую точность при внутреннем тестировании, показал себя гораздо хуже в реальных условиях, пропустив две трети случаев сепсиса и перегрузив врачей ложными срабатываниями.

Инструмент прогнозирования не справился из-за трудно уловимых ошибок в ситуации использования сложных моделей с неограниченным набором признаков. В частности, одним из признаков, используемых для обучения модели, был факт назначения врачом антибиотиков для лечения сепсиса. Другими словами, во время тестирования модель использовала признак из будущего, полагаясь на параметр, который зависел от результата. Конечно, эта особенность не будет доступна во время расчёта прогноза. Интерпретируемость и методы аудита, несомненно, улучшатся, так что мы сможем немного лучше выявлять подобные проблемы. Но не сегодня.

В случае с генеративным ИИ даже те неудачи, которые выглядят очевидными «задним числом», не были обнаружены во время тестирования. Одним из примеров является ранний чат-бот от Bing «Сидней», который сходил с рельсов во время продолжительных разговоров; разработчики, очевидно, не предполагали, что разговоры могут длиться дольше нескольких ходов. К счастью, это были не очень критичные приложения.

Иметь больше эмпирических результатов исследование и экспериментов было бы полезно для понимания медленного распространения инноваций в различных областях и причин этой задержки. Но на данный момент проанализированные нами в предыдущей работе данные согласуются с мнением о том, что уже существуют чрезвычайно строгие ограничения скорости, связанные с безопасностью, в задачах с существенными последствиями. Эти ограничения часто навязаны посредством регулирования, такого как надзор FDA (Управление по санитарному надзору за качеством пищевых продуктов и медикаментов США) за медицинскими устройствами, а также обновлений законодательства, как, например, Закон ЕС об ИИ, который предъявляет строгие требования к ИИ с высоким риском. Фактически, существуют (обоснованные) опасения, что существующее регулирование ИИ с высоким риском настолько обременительно, что может привести к «неуправляемой бюрократии». Таким образом, мы прогнозируем, что медленное распространение продолжит оставаться нормой в задачах с существенными последствиями.

В любом случае, по мере возникновения новых областей с существенным применением ИИ мы можем и должны регулировать его использование. Хорошим примером является «Flash Crash 2010» (6 мая 2010 года в течение 5 минут промышленный индекс Dow Jones рухнул на 9,3%, индекс широкого рынка акций S&P 500 проседал на 8,7%. В момент паники индикатор волатильности VIX взлетал на 58%.), в котором считается, что существенную роль сыграла автоматизированная высокочастотная торговля.

Распространение ограничено скоростью человечества, организационных и институциональных изменений.

Даже за пределами предметных областей, где безопасность критически важна, внедрение ИИ медленнее предположений популярных источников. Например, исследование попало в заголовки СМИ из-за того, что в августе 2024 года 40% взрослых в США использовали генеративный ИИ. Но поскольку большинство людей использовало его нечасто, это привело лишь к 0,5 – 3,5 % рабочих часов (и росту производительности труда на 0,125 – 0,875 п.п.)

Даже не до конца ясно, выше ли скорость распространения ИИ по сравнению с прошлым. В вышеупомянутом исследовании сообщается, что внедрение генеративного ИИ в США происходит быстрее, чем в своё время происходило внедрение персональных компьютеров: 40% взрослых американцев внедряют генеративный ИИ в течение двух лет после выпуска первого продукта на массовый рынок по сравнению с 20% в течение трех лет для ПК. Это сравнение не учитывает разницу в интенсивности внедрения (количество часов использования) или высокую стоимость покупки ПК по сравнению с доступом к генеративному ИИ.

Утверждение о том, что скорость внедрения технологий необязательно увеличивается может показаться удивительным (или даже неверным), учитывая, что цифровые технологии могут одновременно охватывать миллиарды устройств. Важно помнить, что внедрение касается использования ПО, а не доступности. Даже если новый продукт на основе ИИ мгновенно выкладывается в сеть и становится доступным для бесплатного использования всем, людям требуется время для изменения своих рабочих процессов и привычек, осознать преимущества и научиться избегать рисков.

Таким образом, скорость распространения по своей сути ограничена скоростью, с которой не столько отдельные лица, сколько организации могут адаптироваться к технологии. Это общий тренд, который мы также наблюдали для прошлых технологий общего назначения. Распространение происходит не годами, а десятилетиями.

Например, анализ электрификации Пола А. Дэвида показывает, что потребовались десятилетия, чтобы её преимущества полностью материализовались.

Электрические динамо-машины были «везде кроме статистики производительности» в течение 40 лет после первой центральной электростанции Эдисона. Это было не просто технологической инерцией, владельцы фабрик обнаружили, что электрификация не принесла существенного повышения эффективности.

В конечном итоге эффективность появилась благодаря перепроектированию всей структуры фабрик вокруг логики производственных линий. Помимо изменений в архитектуре фабрик, распространение также потребовало изменений в организации рабочих мест и управления процессами, которые можно было разработать исключительно путём экспериментов в разных отраслях. Рабочие получили больше автономии и гибкости, что также потребовало изменения методов найма и обучения.

Внешний мир накладывает ограничения на скорость инноваций в области ИИ

Сложно оспоримый факт: технический прогресс в области ИИ происходит стремительно, но картина становится гораздо менее ясной, если различать методы ИИ и его приложения.

Представим концепцию прогресса в методах ИИ как лестница общности. Каждая следующая ступенька опирается на предыдущую и олицетворяет движение к более общим вычислительным возможностям. Она уменьшает усилия программиста необходимые и достаточные для того, чтобы заставить компьютер выполнить новую задачу и увеличивает набор задач, которые можно выполнить с заданным количеством усилий программиста. Например, машинное обучение увеличивает общность, устраняя необходимость программиста разрабатывать логику для решения каждой новой задачи, требуя вместо этого только сбор обучающих примеров. См. таблицу 1.

Возникает намерение сделать вывод, что усилия, требуемые для разработки конкретных приложений, будут уменьшаться по мере прохождения ступеней лестницы, пока не достигнем искусственного интеллекта, способного устранить необходимость в разработке приложений, делая всё и сразу.

В некоторых областях мы действительно наблюдаем эту тенденцию к снижению усилий разработки. В обработке естественного языка большие языковые модели сделали разработку приложения для интерпретации языка относительно тривиальной задачей. Или рассмотрим игры: AlphaZero может научиться играть в шахматы лучше любого человека, играя самостоятельно, имея лишь описание игры и достаточную вычислительную мощность – это совсем не похоже на то, как раньше разрабатывались программы для игр.

| № | Ступень | Усилия в программировании | Пример |

|---|---|---|---|

| 6 | Модели, настроенные на инструкции | Описать задачу естественным языком | GPT-4 пишет компьютерную программу |

| 5 | Натренированные модели | Собрать небольшой набор данных для дообучения существующей модели/td> | GPT-3 дообученный для анализа юридических документов |

| 4 | Глубокое обучение | Собрать большой набор данных для обучения | Классификатор объектов, обученный на аннотированных данных ImageNet |

| 3 | Машинное обучение | Собрать тренировочный набор данных под каждую задачу и/или подправить алгоритм | Спам-фильтр электронной почты |

| 2 | Компьютеры-мейнфреймы | Написать программу единожды и вызывать её из памяти | BM System/360 |

| 1 | Программируемые компьютеры | Написание программы под прикладную задачу, загружать при необходимости | Harvard Mark I |

| 0 | Оборудование специального назначения | Сборка оборудования под конкретные задачи | Табулятор Холлерита |

Таблица 1. Лестница общности в вычислениях. Для некоторых задач более высокие ступени лестницы требуют меньших усилий программиста, чтобы заставить компьютер выполнить новую задачу, и больше задач может быть выполнено с заданным количеством усилий программиста.

Однако это не было трендом в практических, конкретных приложениях, которые нелегко смоделировать и в которых стоимость ошибки может быть велика. Рассмотрим беспилотные автомобили: во многих отношениях их траектория развития похожа на самостоятельную игру AlphaZero – улучшение технологии позволило им ездить в более реалистичных условиях, что позволило собирать более качественные и более реалистичные данные, что, в свою очередь, привело к улучшению технологии, замкнув цикл. Но этот процесс занял более двух десятилетий вместо нескольких часов в случае AlphaZero, поскольку соображения безопасности наложили ограничения на степень, в которой каждая итерация цикла масштабируется по отношению к предыдущей.

Этот разрыв между возможностями и надёжностью проявляется постоянно. Он стал существенным препятствием для создания полезных ИИ-агентов, которые могут автоматизировать реальные прикладные задачи. Для ясности, многие задачи, для которых сегодня предполагается использование агентов, такие как бронирование поездок или предоставление обслуживания клиентов, гораздо менее значимы, чем вождение, но всё ещё достаточно затратны, поэтому обучение агентов в реальной жизни не является лёгким и простым.

Барьеры также существуют и в приложениях, где безопасность не так критична. В целом, многие знания в организациях неоднозначны и нигде не записаны и тем более не находятся в форме, которую можно применить в обучении. Это означает, что циклы развития с обратной связью должны будут происходит в каждом секторе, а для более сложных задач, возможно, даже должны будут происходить отдельно в разных организациях, что ограничивает возможности для быстрого параллельного обучения. Другие причины, по которым обучение может быть ограничено – это конфиденциальность и приватность: организации и отдельные лица попросту могут не быть склонны делиться своими данными с компаниями ИИ, а регуляторные нормы могут ограничивать, какие типы данных могут быть переданы третьим лицам и в каких контекстах, особенно в здравоохранении.

«Горький урок» в ИИ заключается в том, что общие методы, которые используют увеличение вычислительной мощности, в конечном итоге превосходят методы, которые используют знания человечества с большим отрывом. Это ценное наблюдение о методах, но его часто неверно истолковано, чтобы охватить разработку приложений.

В контексте разработки продуктов на основе ИИ горький урок еще никогда не было даже близок к истине. Рассмотрим рекомендательные системы в социальных сетях: они работают на основе (все более общих) моделях машинного обучения, но это не устранило необходимость ручного кодирования бизнес-логики, интерфейса и других компонентов, которые в совокупности могут включать миллионы строк программного кода.

Дополнительные ограничения возникают, когда нам нужно выйти за рамки обучения ИИ на основе существующих человеческих знаний. Некоторые из наших самых ценных типов знаний являются научными и социально-научными и позволили цивилизации прогрессировать через технологии и крупномасштабные социальные организации (например, правительства). Что потребуется ИИ для расширения границ этих знаний? Вероятно, это потребует взаимодействия или даже проведения экспериментов над людьми и организациями, начиная от тестирования на наркотики и заканчивая экономической политикой. Здесь существуют жёсткие ограничения на скорость получения знаний из-за социальных издержек проведения экспериментов. Общество скорее всего не будет (и не должны) позволять быстрое масштабирование экспериментов для разработки ИИ.

Тесты производительности не измеряют реальную полезность

Разница между методами и прикладным применением имеет важный смысл в том, как мы измеряем и прогнозируем прогресс ИИ. Показатели ИИ полезны для измерения прогресса в методах; к сожалению же, их часто неправильно интерпретируют как изменение прогресса в реальных приложениях, и эта путаница стала причиной большой шумихи о неминуемой экономической трансформации.

Например, сообщается, что GPT-4 попал в 10% лучших сдающих экзамен на адвоката, однако это ничего нам не говорит о способности искусственного интеллекта заниматься юридической практикой. Экзамен на адвоката переоценивает знание предметной области, но недооценивает реальные навыки, которые на порядок сложнее измерить в стандартизированном, управляемом компьютером формате. Другими словами, он подчеркивает именно то, в чем хороши языковые модели — извлечение и применение запомненной информации.

В более широком смысле задачи, которые могут привести к наиболее значимым изменениям в юридической профессии, также являются и самыми сложными для оценки. Оценка проста для таких задач, как классификация юридических запросов по областям права, поскольку существуют чёткие правильные ответы. Но для задач, которые требуют креативности и суждения, таких как подготовка юридических документов, нет единственного верного ответа, и разумные люди могут не согласиться со стратегией. Эти задачи – аккурат те, которые при автоматизации окажут самое глубокое влияние на профессию.

Это наблюдение никоим образом не ограничивается областью права. Другим примером можно рассмотреть разрыв между автономными задачами кодирования, в которых ИИ явно преуспевает, и реальной разработкой программного обеспечения, в которой его влияние сложно измерить, но, скорее всего, оно ничтожно. Даже высоко оценённые эталонные тесты кодирования, выходящие за рамки «детсадовских задач», должны обязательно игнорировать многие аспекты реальной разработки ПО в интересах количественной и автоматизированной оценки с использованием общедоступных данных.

Этот паттерн повторяется неоднократно: чем проще задача измерима контрольными показателями, тем меньше вероятность, что она будет представлять собой сложную, контекстную работу, которая определяет профессиональную практику. Фокусируясь на метриках производительности прогресса методов ИИ, сообщество постоянно переоценивает реальное влияние технологии.

Это проблема «конструктивной валидности», которая относится к тому, измеряет ли тест на самом деле то, что он призван измерять. Единственный верный способ измерить реальную полезность потенциального приложения – это сделать его, а затем протестировать с пользователями в прикладных сценариях (либо заменяя, либо дополняя их труд). Подобные исследования обычно показывают, что профи во многих предметных областях получают выгоду от существующих систем ИИ, но эта выгода, как правило, скромна и больше касается дополнения, чем замены, что радикально отличается от того, что можно было бы оформить на основе статических контрольных показателях, таких как экзамены.

В заключении отметим, что хотя бенчмарки ценны для отслеживания прогресса в методах ИИ, нам следует рассматривать другие виды метрик для отслеживания воздействия ИИ. Измеряя внедрение мы должны учитывать интенсивность использования ИИ. Тип применения также важен: дополнение vs. замена и степень последствий.

Трудность обеспечения конструктивной валидности влияет не только на тесты производительности, но также и на прогнозирование, которое является ещё одним способом оценки будущего воздействия ИИ. Крайне важно избегать неоднозначных результатов для обеспечения эффективного прогнозирования. Способ, которым сообщество прогнозистов достигает этого, заключается в определении контрольных точек с точки зрения специализированных навыков, таких как сдача экзамена. Например, вопрос Metaculus о «паритете интеллекта человека и машины» определяется с точки зрения результатов на экзаменационных вопросах по математике, физике и информатике. Исходя из этого определения неудивительно, что прогнозисты предсказывают 95% вероятность достижения паритета к 2040 году.

К сожалению, это определение настолько размыто, что не имеет большого значения для понимания воздействия ИИ. Как мы видели выше на примере юридических и других специализированных тестов, результаты ИИ имеют настолько низкую конструктивную валидность, что даже не позволяет нам уверенно предсказать, заменит ли ИИ профессиональных работников.

Экономические последствия, скорее всего, будут постепенными

Один из аргументов в пользу того, что развитие ИИ может иметь внезапные, радикальные экономические последствия, заключается в том, что увеличение общности может привести к автоматизации широкого круга задач в экономике. Это связано с одним из определений «общего искусственного интеллекта» (AGI) – унифицированной системы, способной выполнять все экономически значимые задачи.

Согласно обычному технологическому взгляду, подобные неожиданные экономические последствия неправдоподобны. Ранее мы обсуждали причину: внезапные улучшения методов искусственного интеллекта, безусловно, возможны, но не приводят напрямую к экономическим последствиям, которые требуют инноваций и распространения.

Инновации и распространение происходят в цикле обратной связи. В критически важных с точки зрения безопасности приложениях этот цикл обратной связи всегда медленный, но даже за пределами этого круга задач достаточно причин, по которым быстрым он не может быть. С прошлыми технологиями общего назначения соответствующие циклы обратной связи разворачивались десятилетиями, и мы должны ожидать, что тоже самое произойдет и с технологией ИИ.

Ещё один аргумент в пользу постепенного воздействия на экономику: как только мы что-то автоматизируем, стоимость его производства и его ценность, как правило, резко снижается со временем по сравнению со стоимостью человеческого труда. По мере роста автоматизации люди будут адаптироваться и делать фокус на задачах, которые не автоматизированы, вероятно даже на задачах, которые сейчас ещё не существуют (более подробно о них во второй части)

Это означает, что «полный AGI» будет отодвигаться всё дальше во времени, поскольку растущая автоматизация переопределяет экономическую ценность выполняемых задач. Каждая задача, которую люди выполняют сегодня, в один прекрасный день будет автоматизирована, но это вовсе не означает, что человеческий труд станет излишним. Воздействие мощного ИИ будет ощущаться в разных временных масштабах в разных секторах.

О пределах скорости развития ИИ методов

Наш аргумент о медлительности влияния ИИ основан на цикле обратной связи между инновациями и распространением и применим, даже если прогресс в методах ИИ может быть произвольно ускорен. Мы видим, что и преимущества, и риски возникают преимущественно из-за развертывания ИИ, а не из-за разработки; таким образом, скорость прогресса в методах ИИ не имеет прямого отношения к вопросу о влиянии. Тем не менее, стоит обсудить ограничения скорости, которые также применимы к разработке методов.

Проработка исследований вокруг ИИ растёт экспоненциально, при этом скорость публикации статей по AI/ML на arXiv показывает удвоение менее чем за два года. Но неясно, как это увеличение объёма трансформируется в прогресс. Одним из показателей прогресса является скорость оборота центральных идей. К сожалению, на протяжении всей своей истории область ИИ демонстрировала высокую степень «стадности» вокруг популярных идей и недостаточный уровень исследования немодных идей. Ярким примером является откладывание исследований нейронных сетей на протяжении многих десятилетий.

Отличается ли нынешняя эпоха? Не смотря на постоянное накопление идей с возрастающей скоростью, переворачивают ли они устоявшиеся? Архитектурный паттерн «трансформаторы» был доминирующей парадигмой большую часть последнего десятилетия, не смотря на хорошо известные ограничения. Проанализировав более миллиарда ссылок по 241 предмету, Йохан С. Г. Чу и Джеймс А. Эванс показали, что в областях, в которых объем статей выше, новым идеям сложнее, а не легче пробиться. Это приводит к «окостенению канона». Возможно, это описание применимо к текущему состоянию исследований методов ИИ.

Вероятны и многие другие ограничения скорости. Исторически технология глубоких нейронных сетей отчасти сдерживалась из-за особенностей оборудования. Вычислительные и стоимостные ограничения всегда остаются актуальными для новых парадигм, включая масштабирование «времени вывода». Также могут возникнуть и новые замедления: появляются признаки на отход от культуры открытого обмена знаниями в отрасли.

Еще предстоит выяснить в ближайшем будущем, могут ли исследования ИИ, проводимые с помощью ИИ, дать передышку. Возможно, рекурсивное самосовершенствование методов возможно, что приведет к неограниченному ускорению методов. Но обратите внимание, что разработка ИИ уже в значительной степени опирается на ИИ. Более вероятно, что мы продолжим наблюдать постепенное увеличение роли автоматизации в разработке ИИ, чем единичный, прерывистый момент, когда рекурсивное самосовершенствование будет достигнуто.

Ранее мы утверждали, что тесты производительности дают искажённую картину полезности приложений ИИ. Но они, возможно, также привели к чрезмерному оптимизму относительно скорости прогресса методов. Одна из причин заключается в том, что трудно разработать тесты, которые имели бы смысл за пределами текущего горизонта прогресса. Тест Тьюринга был полярной звездой для ИИ в течение многих десятилетий из-за предположения, что любая система, которая его прошла, будет похожа на человеческую в важных отношениях, и что мы сможем использовать такую систему для автоматизации множества сложных задач. Теперь, когда большие языковые модели, возможно, могут пройти его, лишь слабо отвечая ожиданиям, стоящим за тестом, его значимость ослабла.

Также уместна аналогия с альпинизмом. Каждый раз, когда мы решаем задачу (достигаем того, что считали вершиной), мы обнаруживаем её ограничения (понимаем, что находимся на «ложной вершине») и строим новую задачу (нацеливаемся на то, что теперь считаем вершиной). Это приводит к обвинениям в «перемещении ворот», но именно этого и следует ожидать, учитывая внутренние проблемы тестирования методов.

Пионеры ИИ считали, что двумя большими проблемами ИИ (того, что мы теперь называем AGI) являются аппаратное и программное обеспечение. Создав программируемые машины, было ощутимое ощущение, что AGI близко. Организаторы Дартмутской конференции 1956 года надеялись добиться значительного прогресса в достижении цели с помощью «двухмесячных усилий из 10 человек». Сегодня мы поднялись на гораздо больше ступенек по лестнице общности. Мы часто слышим, что все, что нужно для создания AGI, — это масштабирование, или универсальные агенты ИИ, или эффективное на основе выборок обучение.

Полезно иметь в виду, что то, что кажется одним шагом, может таковым не быть. Например, может не существовать единого прорывного алгоритма, который обеспечивает эффективное по образцам обучение во всех контекстах. Действительно, контекстное обучение в больших языковых моделях уже «эффективно по образцам», но работает только для ограниченного набора задач.