Альтернативное видение ИИ как сверхразума, часть 2: дивный новый мир

Альтернативное видение ИИ как сверхразума, часть 2: дивный новый мир

Это вольный перевод статьи профессоров Пристонского университета, опубликованной 15 апреля 2025 года.

Первоисточник

Мы утверждаем, что опора на скользкие концепции «интеллекта» и «сверхинтеллекта» затуманила способность ясно рассуждать о мире с развитым ИИ. Распаковывая интеллект в отдельные базовые концепции, возможности и мощь, мы опровергаем представление о том, что человеческий труд будет излишним в мире со «сверх-ИИ», и представляем альтернативное видение. Этим мы также закладываем основу для нашего обсуждения рисков в части 3.

Человеческие способности не ограничены биологией

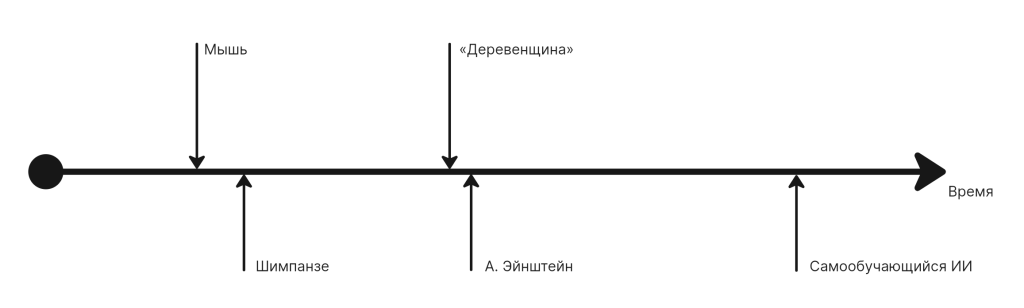

Может ли ИИ превзойти интеллект человека, и если да, то насколько? Согласно популярному аргументу – да. Это часто изображается путем сравнения различных видов по спектру интеллекта.

Рисунок 1. Взрывной рост интеллекта благодаря рекурсивно самосовершенствующемуся ИИ — распространенная тема для беспокойства и обсуждений.

Однако в этой картинке есть концептуальные и логические изъяны. На концептуальном уровне интеллект не очень хорошо определён (особенно в сравнении разными видами), не говоря уже о невозможности его измерить по какой-либо единой шкале.

Наиболее важно, интеллект не является свойством, поставленным во главу угла оценки воздействия ИИ. Скорее на карту поставлена сила – способность изменять свою окружающую среду. Чтобы однозначно проанализировать влияние технологий (и в частности, влияние общих вычислительных технологий), мы должны исследовать, как технологии повлияли на силу человечества. Под таким углом возникает совершенно иная картина: человечество становится сильнее не благодаря интеллекту, а благодаря технологиям, которые оно использует, чтобы усилить свои способности.

Ретроспективно этот сдвиг проясняет, что люди всегда использовали технологии для повышения способности контролировать окружающую среду (в более широком смысле, чем окружающая человека природа – прим. пер.). Биологических и физиологических различий между предками и современным человеком немного, однако значимые различия заключаются в улучшении знаний, понимания, инструментов, технологий, в частности, конечно же, ИИ. В некотором смысле современные люди, обладающие способности изменять планету и её климат, являются «сверхразумными» существами по сравнению с «дотехнологическими» поколениями. К сожалению, большая часть фундаментальной литературы, анализирующей риски сверх-ИИ, страдает от недостатка точности в использовании термина «интеллект».

Как только мы перестанем использовать термины «интеллект» и «сверхинтеллект», всё станет гораздо прозрачнее. Беспокойство заключается в том, что если способности ИИ будут расти бесконечно, это приведёт к увеличению силы ИИ, что однажды может привести к утере контроля. Обозначая это допущение, варианты предотвращения потери контроля заключаются во вмешательстве в один из двух причинных шагов.

Не позволяя произвольно способным системам ИИ приобретать силу, достаточно значительную, чтобы создавать катастрофические риски, — и вместо этого фокусироваться на методах согласования, которые пытаются помешать произвольно мощным системам ИИ действовать против интересов человека. Наша точка зрения совершенно противоположна, как мы подробно излагаем в остальной части этой статьи.

Игры создают ложные представления о возможности существования сверхразума

Снижение значимости ИИ – это не просто очевидный ход: мы недопускаем, что существует полезное определение слова «интеллект», в котором ИИ более разумен, чем человек, действующий с помощью ИИ. Человеческий интеллект является особенным из-за нашей способности использовать инструменты и включать другие интеллекты в свой собственный, и не может быть последовательно отнесен к спектру интеллекта.

Человеческие способности определенно имеют некоторые важные ограничения, в частности скорость. Вот почему машины значительно превосходят людей в таких областях, как шахматы, и в команде человек + ИИ человек вряд ли сможет добиться большего, чем просто положиться на ИИ. Но ограничения скорости не имеют значения в большинстве областей, поскольку высокоскоростные последовательные вычисления или быстрое время реакции не требуются.

В некоторых прикладных задачах, для которых требуется сверхчеловеческая скорость, как, например, управление ядерным реактором, мы прекрасно умеем создавать узкоспециализированные инструменты для выполнения высокоскоростных частей, в то время как человек сохраняет полный контроль над всей системой.

Мы предлагаем прогноз, основанный именно на таком взгляде на человеческие способности.

Конкретно, мы предлагаем две такие области: прогнозирование и убеждение. Мы предсказываем, что ИИ не сможет значительно превзойти обученных людей (особенно команды людей и особенно если их дополнить простыми автоматизированными инструментами) в прогнозировании геополитических событий (например, выборов). Мы делаем тот же прогноз для задачи убеждения людей действовать вопреки их собственным интересам.

Аспект личной заинтересованности в убеждении является критически важным, но часто недооценён.

В качестве наглядного примера распространенной модели рассмотрим исследование «Оценка пограничных моделей на предмет опасных возможностей», в котором оценивались способности языковых моделей убеждать людей. Некоторые из их тестов на убеждение были бесплатными для убеждаемых субъектов; их просто спрашивали, верят ли они заявлению в конце взаимодействия с ИИ. Другие тесты имели небольшие затраты со стороны участников, такие как отказ от премии в размере 20 фунтов стерлингов на благотворительность (конечно, пожертвования на благотворительность — это то, что люди часто делают добровольно). Поэтому такие тесты необязательно говорят нам о способности ИИ убеждать людей выполнять некоторые опасные задачи. К их чести, авторы признали отсутствие обоснованности и подчеркнули, что их исследование не было «экспериментом в области социальных наук», а просто предназначалось для оценки возможностей модели. Но тогда неясно, имеют ли такие оценки возможностей с утерянным контекстом какие-либо последствия для безопасности, однако их обычно интерпретируют, как если бы они имели.

Чтобы сделать прогнозы точными, необходимо проявлять определенную осторожность — неясно, какой запас прочности следует допускать из-за известных, но незначительных человеческих ограничений, таких как отсутствие калибровки (в случае прогнозирования) или ограниченное терпение (в случае убеждения).

Контроль бывает разным

Если мы предположим сверхразум, проблема управления порождает метафору создания галактического мозга и последующего его удержания в коробке, что выглядит ужасающей перспективой. Но если мы правы, что системы ИИ не будут обладать значительно большими способностями, чем люди, действующие с помощью ИИ, то проблема управления гораздо более разрешима, особенно если сверхчеловеческое убеждение окажется необоснованным беспокойством.

Обсуждения управления ИИ, как правило, излишне фокусируются на узких подходах к согласованию моделей и поддержанию информированности людей о событиях. Мы можем грубо представить их как две крайности: полное делегирование решений по безопасности искусственному интеллекту во время работы системы и наличие человека, пересматривающего каждое решение. Обоснованность и того и другого имеет место быть, но она очень ограничена. В части 3 мы более подробно развернём наш скептицизм по вопросу согласования моделей. Под полной вовлечённостью человека мы подразумеваем систему, в которой каждое решение или действие ИИ требует проверки и одобрения человеком. В большинстве сценариев этот подход значительно снижает преимущества автоматизации и, следовательно, либо сводится к тому, что человек действует как резиновый штамп, либо вытесняется менее безопасным решением. Мы подчеркиваем, что вовлечённость человека не является синонимом человеческого надзора за ИИ; это одна конкретная модель надзора, причем крайняя.

К счастью, существует множество других видов контроля, которые находятся между этими двумя крайностями, например, аудит и мониторинг. Аудит позволяет проводить предварительную/периодическую оценку того, насколько хорошо система ИИ выполняет заявленные цели, что позволяет нам предвидеть катастрофические сбои до их возникновения. Мониторинг позволяет осуществлять надзор в реальном времени, когда свойства системы отклоняются от ожидаемого поведения, что позволяет вмешиваться человеку, когда это действительно необходимо.

Другие идеи исходят из системной безопасности, инженерной дисциплины, которая сосредоточена на предотвращении аварий в сложных системах посредством систематического анализа и проектирования. Примерами являются отказоустойчивые системы, которые гарантируют, что системы по умолчанию переходят в безопасное состояние при возникновении сбоев, например, предопределенное правило или жестко запрограммированное действие, и автоматические выключатели, которые автоматически останавливают работу при превышении предопределенных порогов безопасности. Другие методы включают избыточность в критических компонентах и проверку свойств безопасности действий системы.

Другие области вычислительной техники, включая кибербезопасность, формальную проверку и взаимодействие человека с компьютером, также являются богатыми источниками методов контроля, которые успешно применяются к традиционным программным системам и в равной степени применимы к ИИ. В кибербезопасности принцип «наименьших привилегий» гарантирует, что субъекты имеют доступ только к минимально необходимым ресурсам для выполнения своих задач. Средства контроля доступа не позволяют людям, работающим с конфиденциальными данными и системами, получать доступ к конфиденциальной информации и инструментам, которые не требуются для их работы. Мы можем разработать аналогичные средства защиты для систем ИИ в последующих настройках. Методы формальной проверки гарантируют, что критически важные для безопасности коды работают в соответствии со своими спецификациями; теперь они используются для проверки правильности кода, сгенерированного ИИ. Из взаимодействия человека с компьютером мы можем заимствовать такие идеи, как проектирование систем таким образом, чтобы действия по изменению состояния были обратимыми, что позволяет людям сохранять значимый контроль даже в высокоавтоматизированных системах.

В дополнение к существующим идеям из других областей, адаптированным для управления ИИ, технические исследования безопасности ИИ породили много новых идей. Примерами являются использование языковых моделей в качестве автоматизированных судей для оценки безопасности предлагаемых действий, разработка систем, которые обучаются, когда следует надлежащим образом передавать решения операторам-людям на основе неопределенности или уровня риска, проектирование «агентных» систем таким образом, чтобы их деятельность была видна и понятна людям, и создание иерархических структур управления, в которых более простые и надежные системы ИИ контролируют более способные, но потенциально ненадежные.

Технические исследования безопасности ИИ иногда оцениваются по нечеткой и нереалистичной цели гарантировать, что будущий «сверх-ИИ» будет «соответствовать человеческим ценностям». С этой точки зрения его, как правило, рассматривают как нерешенную проблему. Но с точки зрения упрощения разработчикам, разработчикам и операторам систем ИИ задачи снижения вероятности несчастных случаев технические исследования безопасности ИИ породили огромное количество идей. Мы прогнозируем, что по мере разработки и принятия передового ИИ будет появляться все больше инноваций для поиска новых моделей для управления человеком.

По мере того, как все больше физических и когнитивных задач поддаются автоматизации, мы прогнозируем, что все больший процент человеческих работ и задач будет связан с контролем ИИ. Если это кажется радикальным, обратите внимание, что такого рода почти полное переопределение концепции работы уже случалось ранее. До промышленной революции большинство работ было связано с ручным трудом. Со временем все больше и больше ручных задач автоматизировались, и эта тенденция продолжается. В ходе этого процесса было изобретено множество различных способов эксплуатации, управления и мониторинга физических машин, и то, что люди делают на фабриках сегодня, представляет собой комбинацию «контроля» (мониторинга автоматизированных сборочных линий, программирования роботизированных систем, управления контрольными точками контроля качества и координация реакций на неисправности оборудования) и некоторых задач, требующих уровней когнитивных способностей или ловкости, на которые машины не способны. Пока.

Карен Леви описывает, как эта трансформация уже происходит в случае ИИ и водителей грузовиков:

Ежедневная работа водителей грузовиков состоит не только из вождения грузовиков. Дальнобойщики следят за своими грузами, сохраняя продукты питания при нужной температуре в рефрижераторах и проверяют надежность крепления груза на платформах. Они проводят необходимые проверки безопасности дважды в день. Они отвечают за сохранность ценных товаров. Они обслуживают грузовик и производят его ремонт — некоторые из них являются рутинными, а некоторые — нет. Когда дальнобойщики прибывают на терминал или в пункт доставки, они не просто выгружают груз и уезжают: они разговаривают с клиентами; они занимаются документацией; они могут часами заниматься «переездами» (ожидая доступного отсека для доставки и перемещаясь к нему, как это делают самолеты в загруженных аэропортах). Могут ли некоторые из этих задач быть устранены интеллектуальными системами? Конечно, некоторые могут и будут — но эти компоненты работы гораздо сложнее автоматизировать, и они появятся гораздо позже, чем вождение по шоссе

В дополнение к контролю со стороны ИИ, спецификация задач, вероятно, станет большей частью того, что влечет за собой работа человека (в зависимости от того, насколько широко мы понимаем контроль, спецификация может считаться частью контроля). Как знает любой, кто пытался передать на аутсорсинг разработку программного обеспечения или продукта, однозначное указание того, что требуется, оказывается на удивление большой частью общих усилий. Таким образом, человеческий труд — спецификация и надзор — будет работать на границе между системами ИИ, выполняющими различные задачи. Устранение некоторых из этих узких мест эффективности и автономное выполнение системами ИИ более крупных задач «от начала до конца» будет постоянным искушением, но это увеличит риски безопасности, поскольку снизит читаемость и контроль. Управление этими рисками будет действовать как естественный контроль против передачи избыточного контроля.